이번에는 제가 학교에서 진행했던 "저시력자를 위한 실내 근거리 물체 탐지 및 알림 시스템" 프로젝트에 대해서 설명하겠습니다.

본 글은 '왜 이 프로젝트를 했는가', '구체적으로 어떻게 문제를 해결 했는가', '다른 제품과의 차별성', '프로젝트를 하면서 느낀점'에 대해서 세세하게 기록하였습니다.

📌 깃허브 링크: https://github.com/lko9911/Artificial-Intelligence-Project

GitHub - lko9911/Artificial-Intelligence-Project: 강원대학교 인공지능 수업_프로젝트

강원대학교 인공지능 수업_프로젝트. Contribute to lko9911/Artificial-Intelligence-Project development by creating an account on GitHub.

github.com

1. 문제 정의

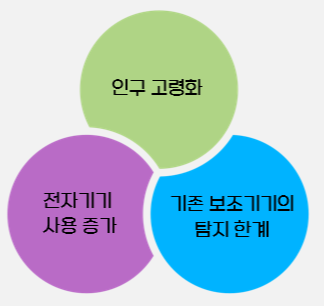

연구의 필요성

저시력자는 물체와의 거리 감각이 떨어지고, 사각지대에서 부상을 입을 위험이 있습니다. 때문에 저시력자의 안전한 이동을 보장하기 위한 연구의 필요성이 높아지고 있습니다.

이러한 문제점을 개선하기 위한 AI를 활용한 실시간 시각 정보를 제공할수 있는 시스템의 개발이 원활이 이뤄지고 있습니다.

기존 제품과의 차별성

"시각"을 보조해주는 AI 도구, 스스템, 제품은 이미 많이 개발되었는데요. 대표적으로 삼성전자의 스마트글래스 와 메타 AI에서 개발한 스마트 안경이 있습니다.

[단독] 삼성, 첫 자체 스마트글라스 내놓는다…'차세대 AI 디바이스로 낙점'

산업 > 산업일반 뉴스: 삼성전자(005930)가 디스플레이 없는 스마트글라스를 이르면 내년 말에 첫선을 보인다. 인공지능(AI) 기술이 고도화하면서 스마...

www.sedaily.com

- https://www.meta.com/kr/ai-glasses/?srsltid=AfmBOop301eZVOWsVOuQ26e9rXsyLUzq0fhD_wdUEuUO3Y0LRu9F3L8b

그렇다면 본 프로젝트가 기존의 시스템과의 어떤 차별성이 있을까?

저희 팀은 다음과 같은 기존제품 대비 차별점을 내세웠습니다.

- 저시력자 타겟 특화 설계: 기존 제품은 일반 사용자를 포괄적으로 설계되었으며 범용적은 목표를 가진다. 때문에 본 시스템은 저시력자 중심의 최적화를 목표로 하였다.

- 경량화된 AI를 적용하여 실시간 처리및 휴대성을 강화

- 소형 객체 탐지성능 강화 솔루션을 제시히여 위험요소를 정확하게 탐지할수 있도록 한다.

- 색맹 사용자를 지원할수 있는 GUI 제공: 박스 색상과 대비를 사용자 맞춤형으로 선택할수 있도록 한다.

- 깊이 정보 기반 위험도 표시로 거리 기반 충돌 위험도를 직접 시각화 한다.

- 개인 맞춤 알림으로 사용자 시력, 반응속도를 기반하여 알림을 커스텀마이징 할 수 있도록 한다.

2. 프로젝트 개요

프로젝트의 목표: 저시력자를 위한 근거리 물체 탐지 및 실시간 알림 시스템 개발

캠, 스마트 안경 등 다양한 장비와의 호환가능한 임베디드 시스템

| 기술 스택 (사용한 기술) | 사용한 모델 및 프로그래밍 라이브러리 |

| 객체 탐지 | YOLOv11n(seg) → YOLOv11n(dectect) |

| 깊이 탐지 | DeeplabV3 (Resnet50 Backbone) |

| 알림 시스템 | OpenCV + Python |

3. 데이터셋 구성

본 프로젝트는 개요에서 설명했다시피 실시간 객체 검출 모델인 YOLO와 단안 깊이 추정 모델인 DeeplabV3을 사용했습니다. 두 모델 모두 지도학습을 하기 때문에 데이터셋은 학습시킬 이미지와 그에 대한 라벨링 데이터가 포함되어야 합니다.

때문에 처음 고안했던 방식은 YOLO-seg와 DeeplabV3 모델을 학습시켜야 하기 때문에, 주변 사물이 포함된 이미지에서 깊이 정보를 담고 있는 깊이 맵(Depth map)과 YOLO-seg의 마스킹 라벨링 데이터가 포함되어야 했습니다.

이에 가장 적합한 데이터는 주변 사물을 포함하는 이미지이면서, 다양한 물체들이 라벨링 되어 있고, 깊이 정보를 담고 있는 Depth map을 가지고 있는 NYU 데이터셋을 사용하기로 결정했습니다.

데이터셋 출처: https://cs.nyu.edu/~fergus/datasets/nyu_depth_v2.html

NYU Depth V2 « Nathan Silberman

NYU Depth Dataset V2 Nathan Silberman, Pushmeet Kohli, Derek Hoiem, Rob Fergus If you use the dataset, please cite the following work: Indoor Segmentation and Support Inference from RGBD Images ECCV 2012 [PDF][Bib] Samples of the RGB image, the raw depth i

cs.nyu.edu

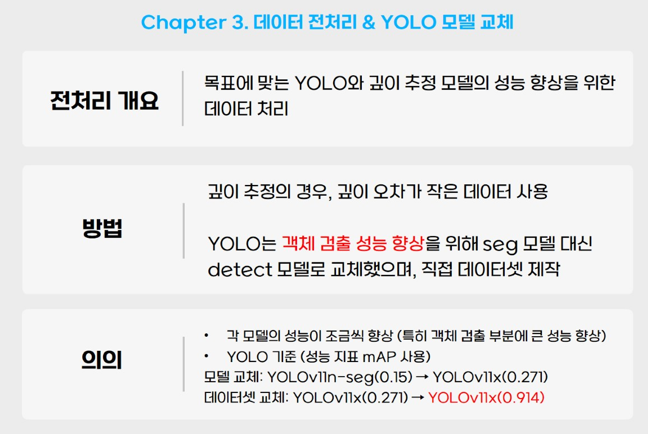

4. 데이터 전처리와 YOLO 모델 교체

당연하지만, 프로젝트에 사용한 두 모델에 학습하는 라벨링 정보(정답 데이터)가 다르기 때문에 NYU 데이터셋을 분리해 각 모델에 맞는 데이터셋 2개를 구성하였습니다. 구체적인 방법론은 다음 글에서 다루겠습니다.

두번째로 처음에 구상했던 YOLO-seg의 성능 mAP가 매우 낮게 나와 모델과 데이터셋을 교체해 목표로 했던 mAP를 달성했습니다.